命令如下:

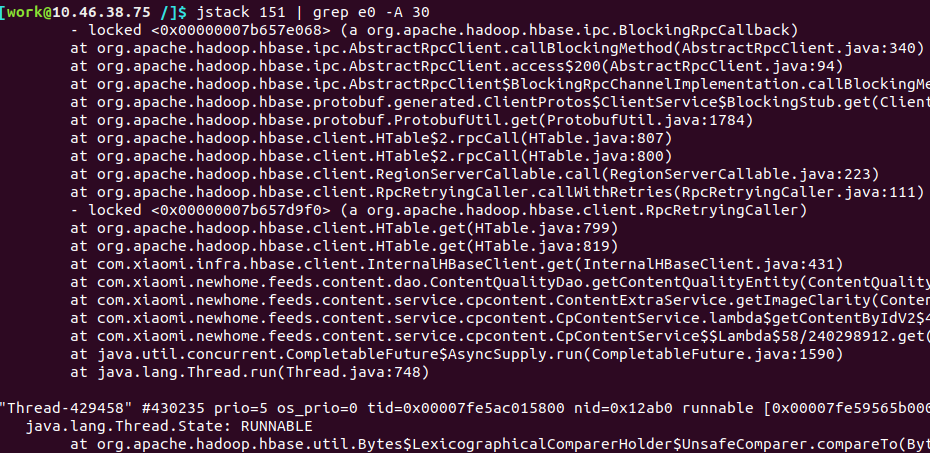

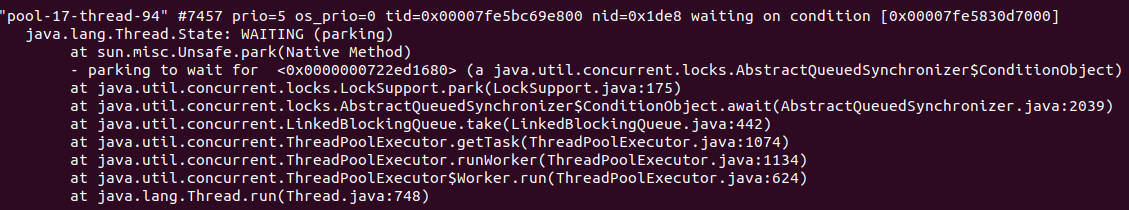

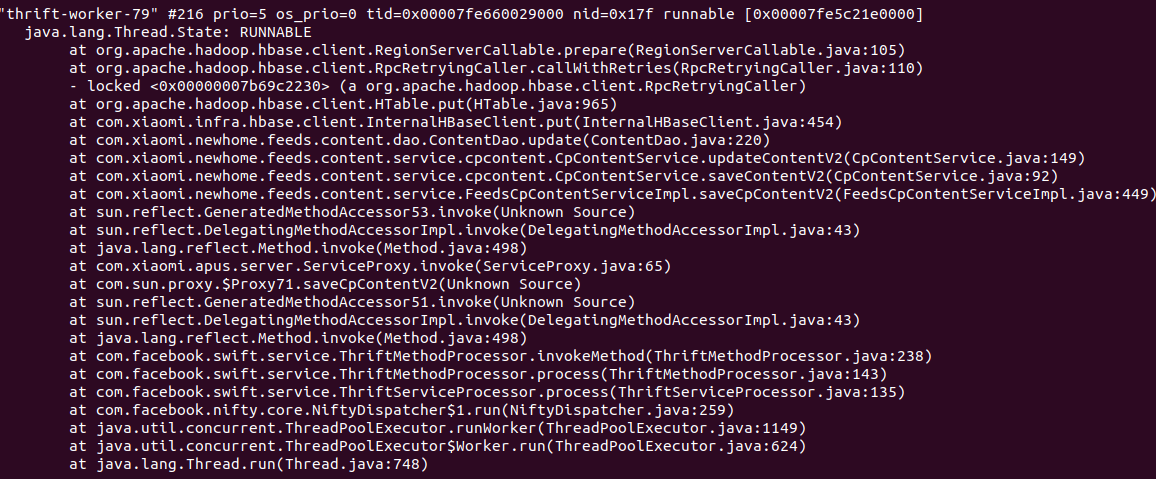

观察线程堆栈日志, 看到上面都是hbase相关, 下面都是在等待队列

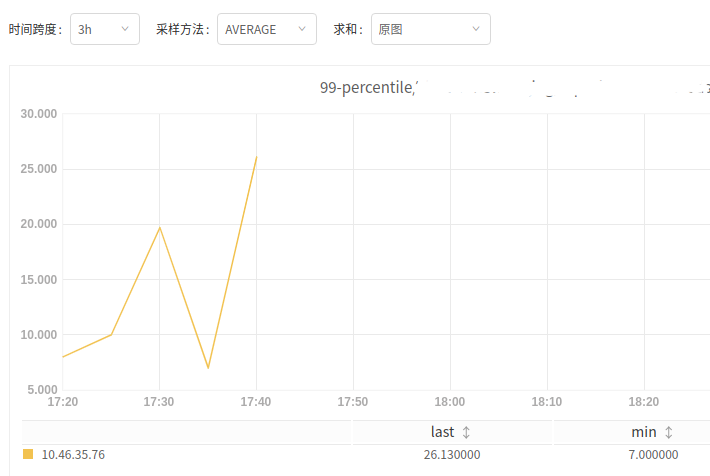

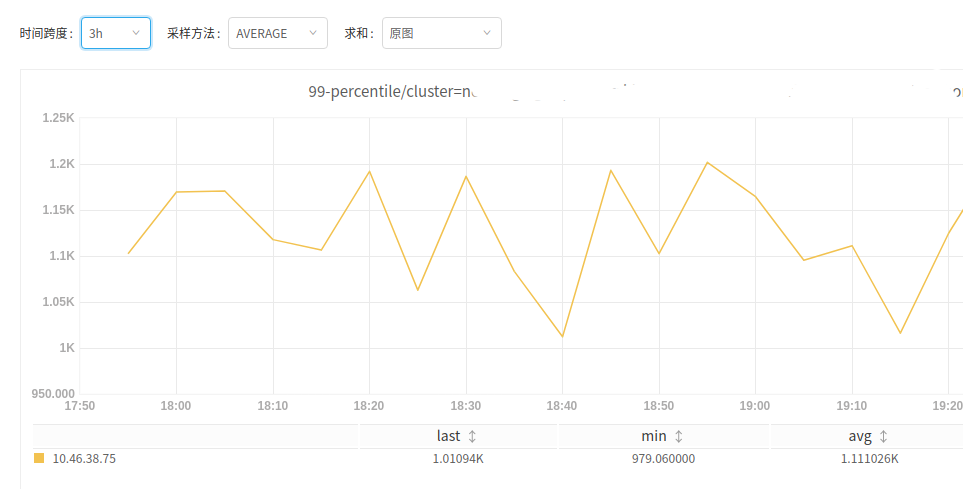

看一把服务这个实例调用hbase的情况

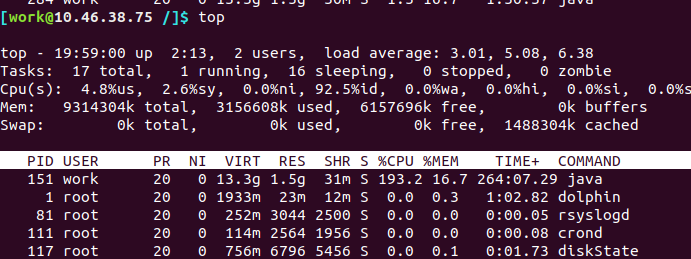

问题实例10.46.38.75, 在10.46.38.75之前的实例10.46.35.76

对比下来, 问题实例上去后, hbase调用基本都是处于超时状态. 应该就是hbase客户端调用出了问题. 导致hbase一直超时, 后面来的请求基本都被卡住了

解决办法, 简单粗暴–重启服务

补充:

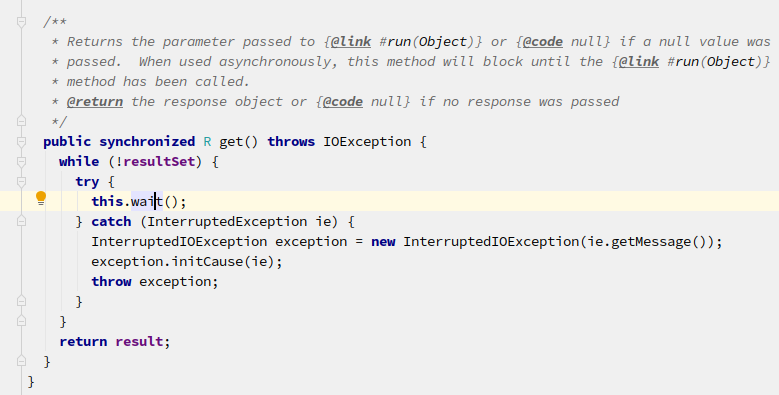

lock的部分:

跟踪hbase的代码, 看不出啥, 只能是看到这边在wait, 但堆栈里并没有关于这个对象的死锁, 这个类是多实例的

此外, 对于lock的定位需要多打印几次堆栈日志, 一次的快照并不能断言就是lock.

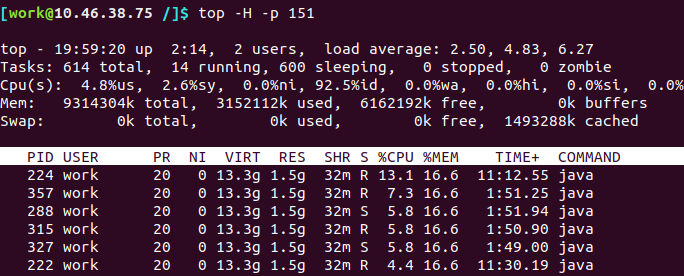

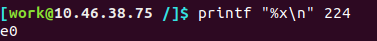

100% cpu部分:

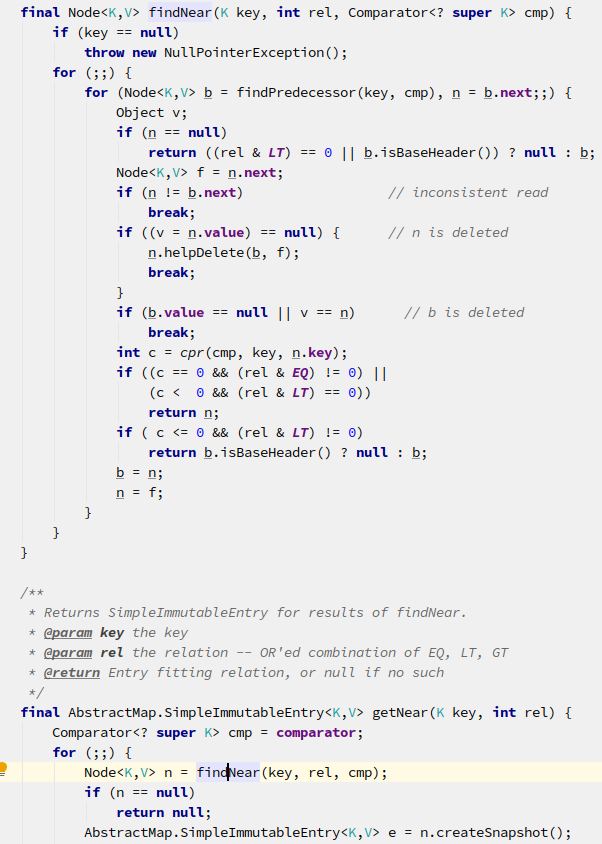

根据runable的线程, 看到不是native方法的, 基本跟hbase有关. 逐个分析, 这个线程最可疑.

追下去会有两个for循环没有退出条件, 可能会死循环, 但没法儿验证